Simpsons regel

Simpsons regel, opkaldt efter den engelske matematiker Thomas Simpson[1], er en metode i numerisk analyse til at udregne cirkaværdien af et bestemt integrale.

Oversigt[redigér | rediger kildetekst]

For et interval af funktionen f som i en vis forstand er "glat", det vil sige uden store udsving eller udefinerede punkter, kan generelt bruges følgende formel til tilnærmet beregning af integralet :

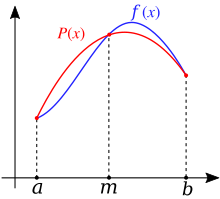

Ideen bag denne formel er at erstatte den egentlige funktion i et interval med en parabelbue der har samme endepunkter og samme midtpunkt som intervallet, og da udregne integralet af denne parabel i stedet. Dette er illustreret i tegningen til højre.

Fejlen ved approximation af et integral med denne metode er lig

hvor c er et tal i intervallet [2].

Er funktionen imidlertid ikke glat over intervallet, for eksempel fordi den har store udsving eller ikke er defineret i et eller flere punkter, giver ovenstående metode ofte dårlige resultater. I sådanne tilfælde kan bruges den mere generelle version af Simpsons regel, givet ved formlen

Her er er intervallet opdelt i n lige store delintervaller hvor n er et lige tal. Desuden er for og . Specielt er og . Ideen er altså at opdele intervallet i mindre delintervaller og bruge Simpsons metode på hvert delinterval, og så summere over resultaterne.

Ovenstående formel kan også skrives, uden brug af summationstegn, som følger:

Fejlen ved denne metode er lig

hvor h er længden af delintervallerne, givet ved , og c er et tal i intervallet [3].

Simpsons regel giver præcise værdier for integraler af polynomier af tredje grad og derunder. Dette er en smule overraskende da Simpsons regel baserer sig på på approksimation med andengradspolynomier, men skyldes at der i formlen for fejlen indgår den fjerde afledede af f som for et polynomie af tredje grad eller derunder er lig nul, og fejlen bliver således tilsvarende altid lig nul.

Alternative, udvidede versioner[redigér | rediger kildetekst]

Simpsons regel som den er beskrevet ovenfor opdeler intervallet i delintervaller af lige stor størrelse. Det kan dog somme tider være praktisk at opdele i delintervaller af forskellig størrelser og fokusere på områder hvor funktionen er problematisk. Dette giver anledning til Simpsons adaptive metode, som blev fremsat af William M. McKeeman i 1962.

Den herover beskrevne metode er desuden baseret på disjunkte delintervaller. Opdeles i stedet i overlappende delintervaller, kan anvendes formlen [4]

Noter[redigér | rediger kildetekst]

Kilder/henvisninger[redigér | rediger kildetekst]

- Atkinson, Kendall A. (1989). An Introduction to Numerical Analysis (2 udgave). John Wiley & Sons. ISBN 0-471-50023-2.

- Press, William H., Brian P. Flannery, William T. Vetterling, og Saul A. Teukolsky (1989). Numerical Recipes in Pascal: The Art of Scientific Computing. Cambridge University Press. ISBN 0521375169.

{{cite book}}: CS1-vedligeholdelse: Flere navne: authors list (link) - Süli, Endre og Mayers, David (2003). An Introduction to Numerical Analysis. Cambridge University Press. ISBN 0-521-81026-4 (hardback), ISBN 0-521-00794-1 (paperback).

{{cite book}}: CS1-vedligeholdelse: Flere navne: authors list (link)

![{\displaystyle [a,b]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9c4b788fc5c637e26ee98b45f89a5c08c85f7935)

![{\displaystyle \int _{a}^{b}f(x)\,dx\approx {\frac {b-a}{6}}\left[f(a)+4f\left({\frac {a+b}{2}}\right)+f(b)\right].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c803efa545e470e97be928947d5d97c06e46553a)

![{\displaystyle \int _{a}^{b}f(x)\,dx\approx {\frac {h}{3}}\left[f(x_{0})+2\sum _{j=1}^{n/2-1}f(x_{2j})+4\sum _{j=1}^{n/2}f(x_{2j-1})+f(x_{n})\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/21e455542927b1e0857003b043ddda255d71da7a)

![{\displaystyle \int _{a}^{b}f(x)\,dx\approx {\frac {h}{3}}\left[f(x_{0})+4f(x_{1})+2f(x_{2})+4f(x_{3})+2f(x_{4})+\cdots +4f(x_{n-1})+f(x_{n})\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/713d7780229f5e260eecd88281e3e93117772383)

![{\displaystyle {\frac {h^{4}}{180}}(b-a)\max _{c\in [a,b]}|f^{(4)}(c)|}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9f6d9ff2c1e58704da3aae21ae9a838ca169c053)

![{\displaystyle {\begin{aligned}\int _{a}^{b}f(x)\,dx\approx {\frac {h}{48}}{\bigg [}&17f(x_{0})+59f(x_{1})+43f(x_{2})+49f(x_{3})+48f(x_{4})+\\&\cdots +48f(x_{n-4})+49f(x_{n-3})+43f(x_{n-2})+59f(x_{n-1})+17f(x_{n}){\bigg ]}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/42fc38811920a0a29a3b5aa8ce0b347dded6e8cd)